DeepSeek-R1: una empresa china lanza un modelo de IA que sorprendió a científicos de todo el mundo

La empresa china DeepSeek ha lanzado su modelo de razonamiento llamado DeepSeek-R1 que ha sorprendido a todos.

En los últimos años, cuando hablamos de inteligencia artificial (IA), inmediatamente pensamos en ChatGPT, que destacó por su capacidad de comprender y generar respuestas. Aunque ChatGPT es el más popular entre todos los chatbots con funciones similares, empresas como Google, Meta y X han lanzado sus versiones que compiten con resultados cada vez mejores. Además de aplicaciones cada vez más diversas.

En 2024, OpenAI decidió avanzar aún más con el anuncio de modelos de razonamiento, denominados o1 y o3. Estos modelos están entrenados para abordar problemas que requieren razonamiento, como resolver problemas matemáticos y deducir en tiempo real. Estos modelos de razonamiento utilizan diferentes técnicas que intentan imitar la forma en que razona el cerebro humano.

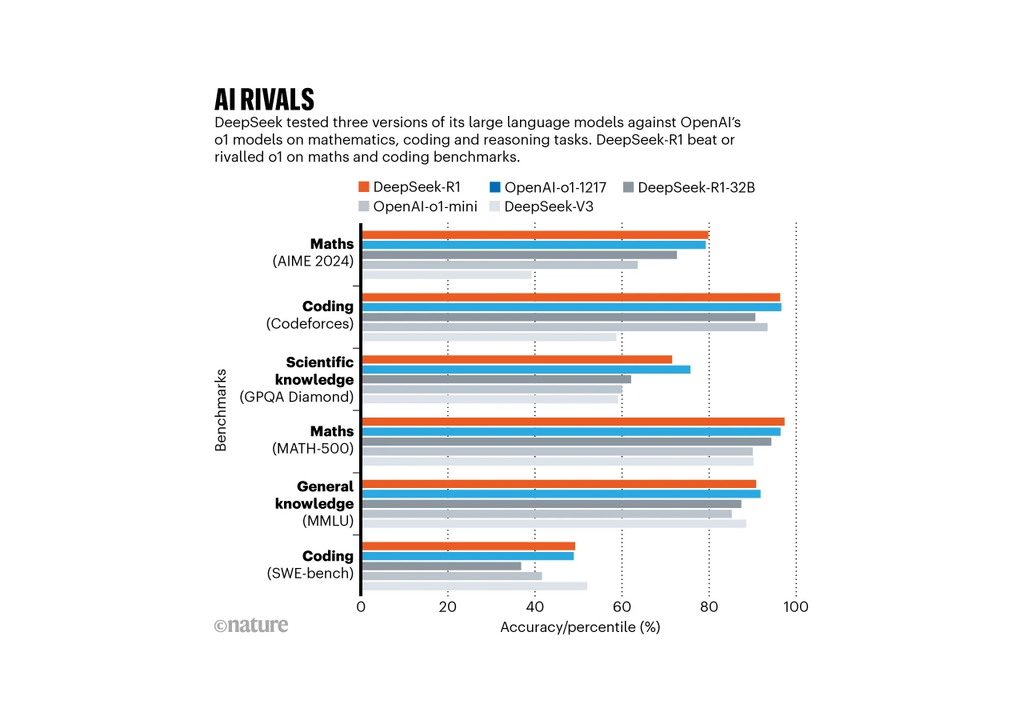

Poco más de un mes después del anuncio de o3, China entró en juego cuando la empresa DeepSeek lanzó su modelo DeepSeek-R1. Lo que nos llamó la atención es que el modelo parece haber superado a otros LLM disponibles en grandes empresas. Esto llamó la atención de varios expertos en inteligencia artificial que ya se han pronunciado sobre el tema. El modelo chino ha establecido nuevos récords de desempeño en los benchmarks globales.

LLM

Los grandes modelos lingüísticos (LLM) son modelos entrenados con una gran cantidad de datos textuales de distintos tipos. La mayoría de los LLM se construyen utilizando Transformers y sus capas de atención, así como redes neuronales. Los Transformers fueron introducidos por Google en 2017 y funcionan para capturar relaciones complejas entre palabras y contextos en una secuencia.

Algunos LLM disponibles hoy en día son GPT de OpenAI, Gemini de Google, Grok de X y Llama de Meta. Estos modelos pueden realizar tareas como responder preguntas, escribir textos creativos y algunos incluso pueden generar imágenes. A pesar de esto, estos modelos tienen limitaciones principalmente en el aspecto más lógico y con esto se inició una carrera por mejores modelos, como los modelos de razonamiento.

Modelos de razonamiento

En 2024, OpenAI sorprendió al anunciar modelos de razonamiento denominados o1 y o3. Estos modelos están capacitados para incorporar capacidades lógicas, deductivas y analíticas en sus operaciones. Están diseñados para simular cómo es el proceso de pensamiento humano, como hacer inferencias entre hechos e información y tomar decisiones durante el proceso de toma de decisiones.

Generalmente, los LLM tradicionales responden preguntas utilizando su base de datos, mientras que los modelos de razonamiento analizan diferentes factores e información, dividiendo la pregunta en varias otras. Un ejemplo es que un problema matemático se puede dividir en varias partes donde se abre cada paso del proceso.

DeepSeek-R1

La empresa DeepSeek es una startup china que se fundó oficialmente en 2023 como una empresa secundaria del High-Flyer de 2015. Desde 2023, DeepSeek ha estado lanzando modelos como su primer llamado DeepSeek Coder. En enero de este año, la compañía impresionó al mundo entero al anunciar DeepSeek-R1, que es un modelo de razonamiento que tiene un rendimiento comparable e incluso mejor que el o1 de OpenAI.

Pero lo que destaca de DeepSeek-R1 fue principalmente el uso de recursos limitados respecto a otros, siendo mucho más eficiente. Además, se lanzó como modelo abierto para que investigadores de todo el mundo puedan estudiarlo y mejorarlo. El modelo se puede reutilizar y es mucho más económico que los modelos de la competencia que son más grandes en costo y tamaño.

Comparación con otros modelos

Para poner en juego DeepSeek-R1, la empresa realizó algunas pruebas clásicas que se detallan en un artículo publicado por la empresa. En estas pruebas, el modelo logró una precisión del 97,3 % en el conjunto de problemas matemáticos MATH-500 desarrollado por investigadores de la Universidad de California. Además, el modelo logró superar al 96,3 % de los participantes humanos en la competencia Codeforces.

Los resultados están a la par de las capacidades del modelo o1 de OpenAI e incluso lo superan en algunas tareas. Todavía falta una comparación con el modelo o3 lanzado a finales de 2024. Aún se están realizando otras pruebas, según el artículo de la revista Nature, en cálculos específicos de óptica cuántica, el DeepSeek-R1 superó al o1.

Referencia de la noticia:

Gibney 2025 China’s cheap, open AI model DeepSeek thrills scientists Nature