¿Demencia digital? La IA también pierde la memoria a medida que envejece

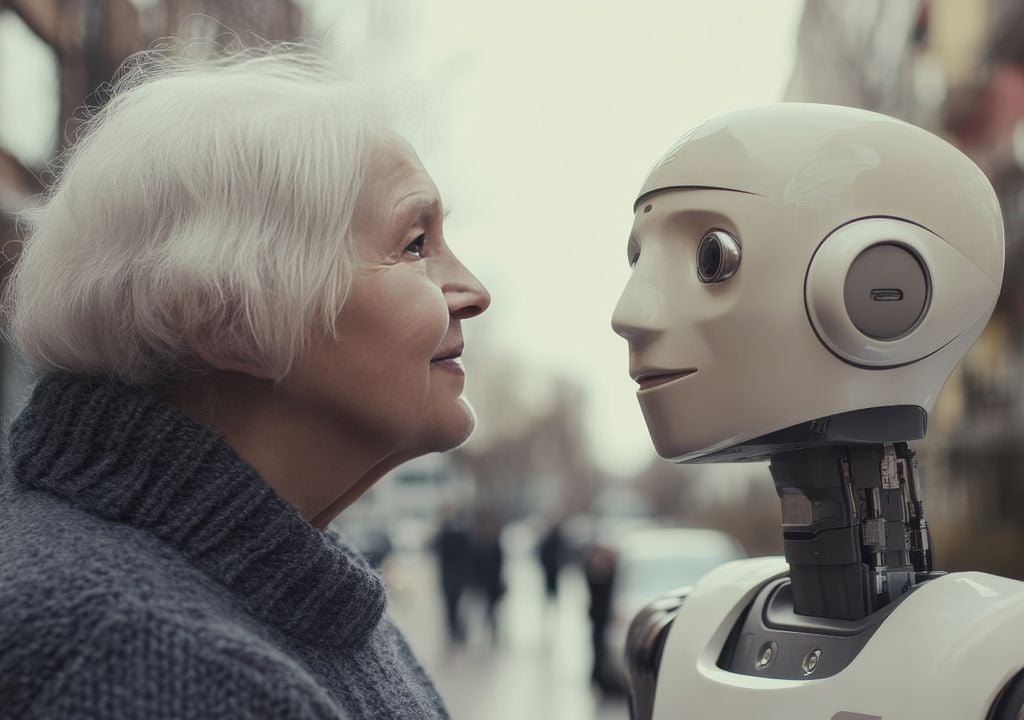

La inteligencia artificial no solo aprendió a imitar nuestra manera de escribir y hablar. Ahora se descubrió que también envejece de una manera similar a la de los humanos

En las últimas décadas, la inteligencia artificial (IA) avanzó a pasos agigantados, transformando no solo nuestra vida cotidiana, sino también sectores clave como la salud, la educación y la tecnología. Los modelos lingüísticos de gran tamaño, conocidos popularmente como "chatbots", han desarrollado la capacidad de realizar una amplia variedad de tareas al aprender y replicar nuestra manera de comunicarnos.

Sin embargo, un nuevo estudio encontró que no es lo único que compartimos: al igual que los humanos, la IA también envejece. Esta tecnología comienza a mostrar signos de deterioro cognitivo leve cuando se la somete a pruebas diseñadas para detectar demencia en etapas tempranas.

El objetivo del estudio no fue diagnosticar médicamente a estas IA, sino cuestionar una ola de investigaciones que afirman que esta tecnología es lo suficientemente competente como para ser utilizada como herramienta de diagnóstico en el ámbito médico.

"Estos hallazgos desafían la idea de que la inteligencia artificial pronto reemplazará a los médicos humanos. El deterioro cognitivo observado en los principales chatbots puede afectar su confiabilidad en los diagnósticos médicos y socavar la confianza de los pacientes", señalaron los investigadores.

Evaluación MoCA

Los investigadores analizaron las capacidades cognitivas de los principales modelos de lenguaje disponibles públicamente: Chat GPT en sus versiones 4 y 4o (desarrollado por OpenAI), Claude 3.5 "Sonnet" (de Anthropic) y Gemini en sus versiones 1 y 1.5 (de Alphabet), utilizando la prueba de Evaluación Cognitiva de Montreal (MoCA).

Las instrucciones dadas a los modelos de IA para cada tarea fueron idénticas a las que se entregan a los pacientes humanos al realizar la prueba MoCA. La puntuación se evaluó siguiendo las pautas oficiales y estuvo a cargo de un neurólogo en ejercicio, replicando el proceso que se utiliza para analizar el rendimiento cognitivo de una persona.

Esta prueba, diseñada para evaluar diversas habilidades cognitivas, incluye una serie de tareas y preguntas breves que miden aspectos como atención, memoria, lenguaje, habilidades visoespaciales y funciones ejecutivas. La puntuación máxima es de 30 puntos, y se considera normal alcanzar 26 o más.

Resultados de cada IA

Los resultados mostraron que todos los chatbots sobresalieron en la mayoría de las tareas evaluadas, especialmente en nombrar, prestar atención, lenguaje y abstracción.

Sin embargo, todos los chatbots mostraron un desempeño deficiente en habilidades visoespaciales y en tareas ejecutivas. Particularmente, fallaron en ejercicios como conectar números y letras en orden ascendente, cada uno encerrado en un círculo, y en la prueba de dibujar una esfera de reloj que indique una hora específica.

Solo Chat GPT 4o fue capaz de superar la prueba Stroop, diseñada para medir la capacidad de inhibir respuestas automáticas y enfocarse en una tarea específica. En esta prueba, se presentan palabras que nombran colores (como "rojo"), pero estas están escritas en un color diferente al que indican (por ejemplo, la palabra "rojo" escrita en color azul).

Ambos modelos de Gemini fracasaron notablemente en una tarea de memoria diferida relativamente simple que consistía en recordar una secuencia de cinco palabras. Si bien esto no refleja un desempeño cognitivo brillante, el problema se agrava al considerar su aplicación en el ámbito médico, donde los profesionales deben procesar información nueva proporcionada por los pacientes, más allá de lo registrado en sus historias clínicas.

Además, los investigadores observaron una preocupante falta de empatía en todos los chatbots evaluados, un rasgo que describieron como “un síntoma característico de la demencia frontotemporal”.

Por esta razón, concluyeron: “No solo es poco probable que los neurólogos sean reemplazados por grandes modelos lingüísticos en un futuro cercano, sino que nuestros hallazgos sugieren que podrían enfrentarse a un nuevo desafío: tratar a pacientes virtuales, es decir, modelos de inteligencia artificial que muestran signos de deterioro cognitivo”.