¡Todo lo que se necesita es atención! ¿Cuál es el trabajo más importante de la inteligencia artificial?

El artículo de Google que revolucionó las técnicas de inteligencia artificial y está detrás de varias herramientas importantes.

Estamos entrando en una era en la que la inteligencia artificial está cada vez más presente en nuestras vidas. Desde sistemas de recomendación en diversas páginas web hasta aplicaciones como ChatGPT. Esto ha sucedido principalmente por el avance de la inteligencia artificial y toda la tecnología implicada tanto en cuestiones técnicas como de hardware.

Una de las principales razones de este avance se encuentra en el área de NLP o procesamiento del lenguaje natural, con los modelos de lenguaje a gran escala o LLMs. Estos sistemas se crearon para generar textos a la vez que utilizan datos para entrenar la comprensión y la generación de textos. Se utilizan en herramientas como ChatGPT y Gemini que pueden responder preguntas y realizar tareas.

En 2017, Google publicó el artículo "Attention Is All You Need" que presentaba una arquitectura llamada Transformer. La arquitectura tiene un mecanismo llamado atención que permite al modelo "prestar atención" y observar patrones y relaciones en textos e imágenes. Recientemente, OpenAI anunció o3, que utiliza Transformers como base de su algoritmo, pero ¿qué son los Transformers? ¿Y cómo cambió el mundo el artículo de Google?

Attention is All You Need

El artículo "Attention Is All You Need" fue publicado en 2017 por un grupo de investigadores de Google. El artículo traía, por primera vez, la arquitectura llamada Transformer para su uso en PNL y problemas que involucran secuencias. Detrás de Transformer, Google insertó un mecanismo llamado motor de atención.

La arquitectura se ha puesto a prueba en diversas tareas, como la traducción de un idioma a otro, donde la comprensión de secuencias y relaciones es fundamental. Con el tiempo, la idea de Transformer se ha ampliado a imágenes e incluso vídeos. Sin embargo, el uso más conocido y popular de esta arquitectura es en modelos lingüísticos a gran escala, o LLM, que se entrenan con una gran cantidad de datos.

Atención

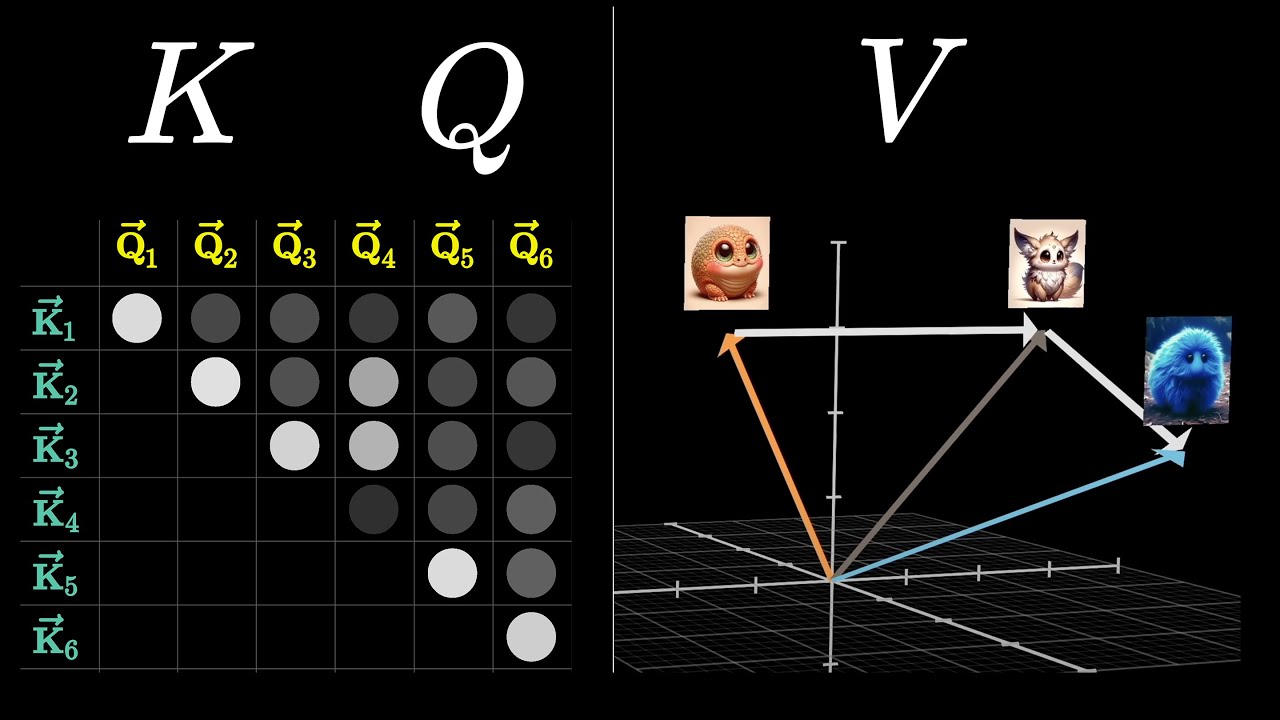

Dentro de Transformer, el mecanismo llamado Atención es la parte más importante del artículo. Funciona centrándose en las partes más relevantes de los datos mediante operaciones matemáticas. Por ejemplo, estos mecanismos de atención hacen que el modelo elija las palabras más importantes de una frase o un texto. Así, las predicciones dependen de las partes más relevantes.

Este mecanismo asigna pesos a cada elemento de una secuencia de entrada y, en función de la tarea a realizar, se calcula la relevancia. Los pesos se calculan mediante operaciones entre vectores para alcanzar elementos distantes en la misma secuencia. Otro ejemplo es la autoatención, que se utiliza para captar relaciones como las dependencias entre las palabras de una frase.

Transformers

Y los Transformers utilizan los mismos mecanismos de atención que inspiraron el nombre del artículo "Attention Is All You Need". Consta de dos partes: el codificador y el descodificador. El codificador procesa la entrada y crea representaciones internas que son importantes para la red. El descodificador toma estas representaciones y genera salidas.

Cada parte de Transformer se compone de varias capas, como las capas de autoatención y las capas de red neuronal. Estas capas se combinan para aprender diferentes relaciones en los datos, desde relaciones locales hasta relaciones más generales. El mecanismo de atención de Transformer permite procesar simultáneamente grandes volúmenes de datos.

Aplicaciones

Las aplicaciones de los Transformers son innumerables y cada vez están más presentes en la vida cotidiana. Un ejemplo es ChatGPT, de OpenAI, que batió el récord de usuarios en un día. Además de ChatGPT, Gemini de Google y Llama de Meta también se basan en Transformers para generar textos que dependen de la entrada del usuario. También se utilizan ya generadores de imágenes y vídeos, como Grok 2 de X.

OpenAI anunció recientemente el modelo o3, capaz de realizar tareas más complejas y conocido como modelo de razonamiento. El o3 se basa en el o1 que se lanzó en septiembre de 2024. Ambos modelos, denominados modelos de razonamiento, se basan en Transformers junto con otros algoritmos como el aprendizaje por refuerzo.

Referencia de la noticia:

Vaswani et al. 2017 Attention Is All You Need Google